Google Search Console — неотъемлемый инструмент SEO-оптимизатора, работающего с любой поисковой системой. GSC находит десятки технических ошибок, которые мешают продвижению в поисковиках, а также помогает получить статистику по запросам и найти недооптимизированные страницы с низким CTR.

Важно помнить, что консоль — просто инструмент, который подсказывает слабые места. Показатели лучше анализировать параллельно с данными, полученными из парсера или логов (если ищете дубли метаданных, страницы не в индексе и прочее), а также из других сервисов аналитики. Игнорировать GSC не стоит, чтобы не упустить критические ошибки, которые повлияют на место в поисковой выдаче.

В этом посте я рассмотрю отчёты Google Search Console (как старой, так и новой версии) и расскажу, как они помогают в работе SEO-оптимизатора.

1. Отчёты первостепенной важности

1.1. Отчёт об эффективности

Этот отчёт один из наиболее важных для SEO-специалиста.

Помогает узнать:

- Запросы, по которым пользователи переходят на сайт или по которым есть показы в Google, их среднюю позицию и процент кликабельности (CTR);

- Страницы с аналогичными параметрами;

- Страны проживания пользователей;

- Устройства;

- Вид в поиске, по которому осуществляются переходы или есть показы.

С помощью отчёта об эффективности SEO-оптимизатор может:

- Провести анализ динамики трафика или показов на сайте;

- Найти слабые места в оптимизации;

- Выделить запросы, по которым снизился или вырос трафик;

- Выяснить, поступает ли трафик с Google Images или Google Video;

- Найти страницы с низким CTR (для повышения привлекательности в выдаче);

- Выяснить, какой процент пользователей просмаривает сайт с мобильных устройств, а какой с десктопных.

Тут важно уточнить, что полагаться только на данные GSC не стоит, так как информация не всегда точная. Для примера покажу график кликов/показов и его общие данные при фильтрации по запросу. После 19 августа Google исключил редкие запросы из суммированных данных, потому картина может очень отличаться от реальной.

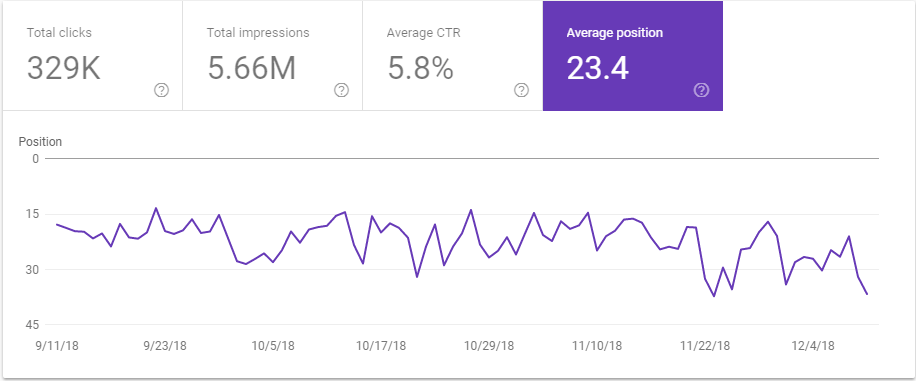

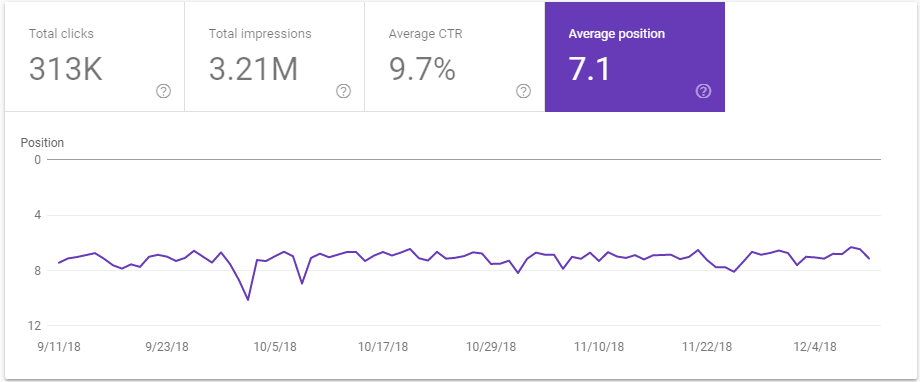

Показатель средней позиции — тоже сомнительная величина, если смотреть на общую картину. Например, поставив фильтрацию по стране, мы видим, насколько сильно разнятся данные.

Данные интернет-магазина без фильтрации по целевой стране

Данные интернет-магазина с фильтрацией по целевой стране

Для приближённых к действительности показателей следует отдельно анализировать каждый интересующий запрос и страницу.

Для этого используют плагин «Search Analytics for Sheets». Его неоспоримый плюс — выгружает не 1000 запросов-страниц, а гораздо больше. Как показывает практическое применение этого дополнения, оно всё равно не выгружает всю аналитику, а только рандомное число (от чего зависит — пока непонятно). Это может быть 12 000, может 18 000, а может и 7 000. Выгрузив два отчёта по срезам (например, за две недели) и сравнив их, вы получаете полноценную картину того, как изменились клики и показы по странице или запросу. Подробнее о том, как установить и использовать этот плагин, читайте в посте.

1.2. Отчёт «Покрытие» в GSC

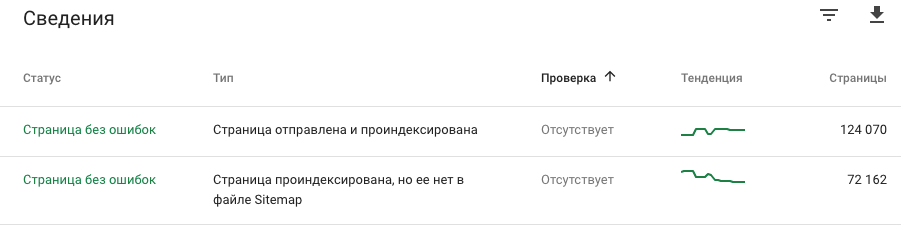

Для SEO-оптимизатора крайне важно, чтобы все продвигаемые страницы находились в индексе поисковика. В обновлении Google Search Console представлен детализированный отчёт об индексации страниц, поделённый на 4 большие категории:

- «Ошибки» — такие страницы не будут проиндексированы; сюда попадают страницы, закрытые в , с 5хх или 4хх ответом сервера или длинной цепочкой редиректов. Следите, чтобы в эту группу не попали важные для продвижения страницы.

- «Предупреждения» — сюда попадают страницы, которые закрыты в robots.txt, но Google продолжает их индексировать. Такие страницы мешают продвижению (создавая дубли основных), если видите подобное — используйте или X-Robots-Tag для исключения ненужных страниц.

- «Страницы без ошибок» — полезный отчёт, который помогает определить, какие страницы, не указанные в Sitemap, попадают в индекс поисковика, и на что тратится краулинговый бюджет (важно для больших сайтов-пациентов).

Если эти страницы не приносят трафик и не нужны в поиске, их закрывают от индексации.

- «Исключено» — спорный статус для страниц, так как многие из них при проверке находятся в индексе Google (особенно это касается страниц «Страница просканирована, но пока не проиндексирована» и «Обнаружена, не проиндексирована»). Отчёт не остаётся пустым, поскольку туда попадают страницы с настроенным «canonical», страницы с 3хх редиректом и другие. Интересный тип исключения — «Страница является копией. Канонические версии страницы, выбранные Google и пользователем, не совпадают». Не игнорируйте эту проблему. Тут показано несовершенство поисковых алгоритмов. При ручной проверке выясняется, что поисковик склеивает, например, две страницы разных карточек товара. Ещё этот статус помогает выявить ошибку отсутствия редиректа со страницы со слешем на ту же без него (или наоборот).

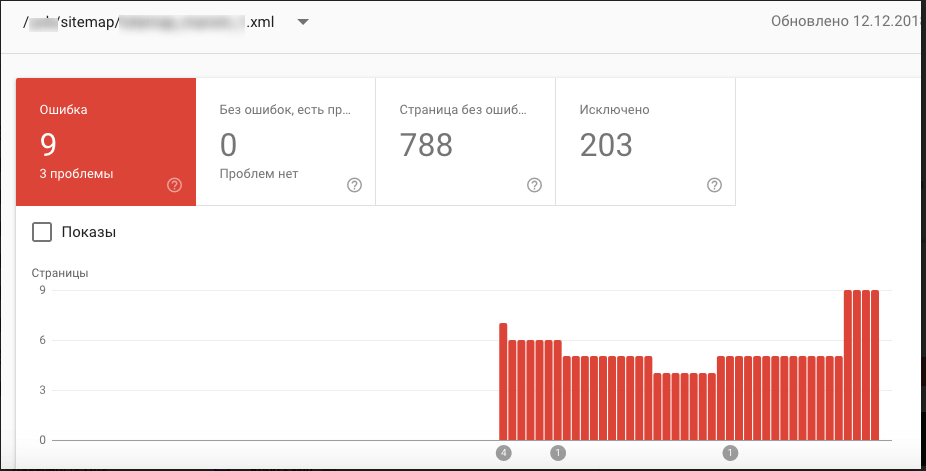

Возможность смотреть статус покрытия сайта по отдельным Sitemap — однозначный плюс для SEO-оптимизатора в новой версии GSC, например, раздробив карту сайта по 1 000 URL в каждой. Таким образом, вы не упустите страницы, которые скрываются из-за ограничений отображения количества строк в консоли.

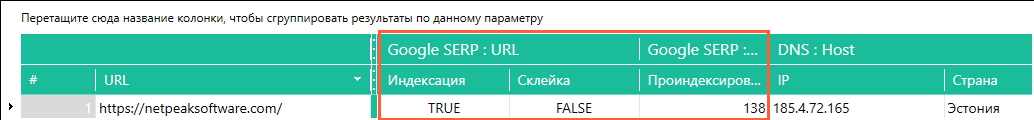

К отчёту «Покрытие», как и отчёту об «Эффективности», стоит относиться как к подсказкам, а не доказанной истине. Перепроверить полученную информацию можно с помощью инструмента Netpeak Checker, узнав, сколько страниц проиндексировано на сайте:

- Запускаем сканирование сайта, выбираем пункт «Google SERP: URL».

- Значение в колонке «Индексация» показывает, проиндексирован ли сайт.

- В колонке «Проиндексировано» отражается количество страниц сайта в индексе.

Ещё один момент в этом отчёте GSC, на который не стоит полагаться — дата последнего сканирования. Только лог-файлы покажут достоверную информацию о посещении Googlebot-ом определённой страницы. При сравнении дат в GSC и лог-файлах видно, что они могут сильно отличаться.

Отчёт «Покрытие» помогает SEO-специалисту обнаружить проблемы технического характера на сайте:

- проблемы работы сервера (5хх ошибки);

- страницы с 4хх ответом сервера;

- бесконечные редиректы;

- страницы, по ошибке закрытые от индексации;

- страницы, закрытые в robots.txt, но попавшие в индекс;

- дубликаты и мусорные страницы, на которые тратится краулинговый бюджет или которые находятся в индексе;

- важные для продвижения страницы, не попавшие в индекс.

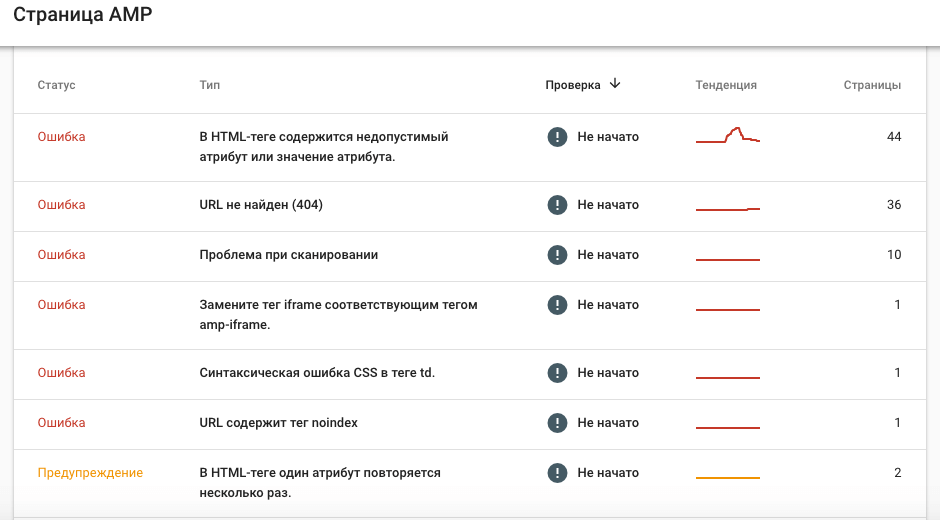

1.3. Отчёты об «Удобстве для мобильных» и «AMP-страницах»

В эру Mobile-First-Index для продвижения в Google важно следить за оптимизацией страниц под мобильные устройства.

В этих отчётах видны ошибки, которые стоит исправить для корректного отображения на смартфонах.

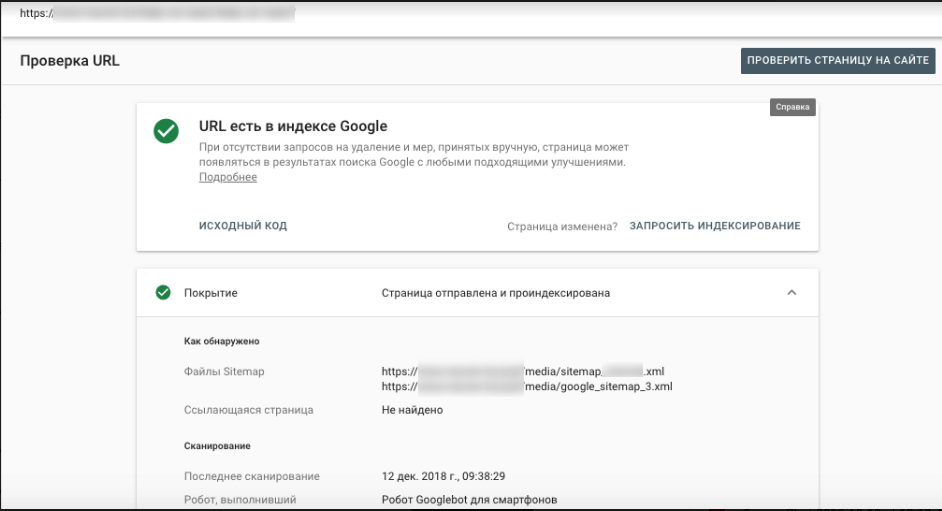

2. Функция «Проверка URL» в новой GSC

Одна из фич, которых не хватало в старой Google Search Console — проверка URL. Просто отправьте URL на проверку с помощью этой функции, если нужно быстро проверить одну страницу: в индексе или нет; если не в индексе, то почему; когда было последнее сканирование ботом и каким (десктопным или мобильным); как обнаружена страница..

3. Отчёты в старой GSC, которые всё ещё нужны

Эти вкладки всё ещё не перенесены из старого инструмента в новый, но менее полезными не становятся. Рассмотрю отчёты, о которых не стоит забывать SEO-специалисту.

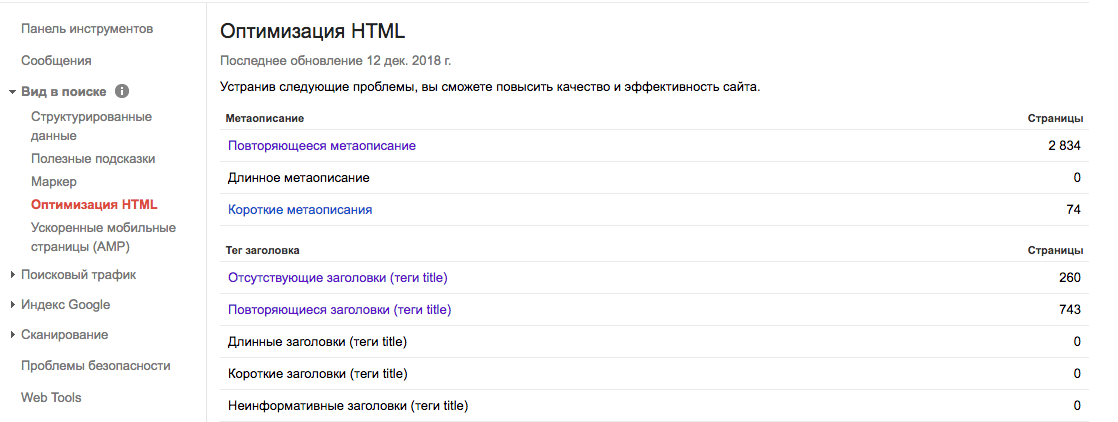

3.1. Оптимизация HTML

Этот отчёт сигнализирует SEO-оптимизатору об отсутствующих, коротких, повторяющихся или длинных метаданных без сканирования сайта парсерами.

3.2. Структурированные данные

Каждый SEO-специалист должен знать, что в этом отчёте будут отображены ошибки, которые не дают использовать потенциал расширенных сниппетов в поисковой выдаче и портят их вид.

3.3. Таргетинг по странам и языкам

Если анализируемый сайт-пациент мультиязычный или мультирегиональный, то тут будут показаны ошибки, связанные с атрибутом hreflang. После корректной настройки намного легче продвигать разные языковые версии сайта в целевых странах.

3.4. Инструмент проверки файла robots.txt

Как и Яндекс.Вебмастер, Google Search Console помогает протестировать файл robots.txt перед загрузкой на сайт и узнать:

- Не будут ли закрыты от индексации важные страницы;

- Корректно ли указаны директивы.

С помощью этого инструмента вы не допустите нелепую ошибку, закрыв от индексации целый каталог вместо одной страницы.

Подводим итоги

Google Search Console — помощник как опытного, так и начинающего SEO-оптимизатора, который указывает на слабые стороны сайта-пациента.

Каждый специалист определяет для себя важность того или иного отчёта и задачи, которые ставит перед этим инструментом.

- Первым делом, увидев резкую просадку в Google, необходимо обратиться к вкладке «Меры, принятые вручную».

- Увидев просадку по одной странице, стоит анализировать запросы, по которым перестал поступать трафик.

- Заметив в выдаче нецелевую страницу, нужно запустить «Проверку URL».

Всё это можно выполнить в инструменте Google Search Console.