Владельцы сайтов нередко сталкиваются с проблемой, когда без очевидных причин начинает проседать или перестает расти трафик. Если такая динамика носит устойчивый характер — необходимо принимать меры. Первым делом следует попытаться понять причину проблемы. Подобная картина может наблюдаться в ряде случаев:

1. Проведение глобальных изменений на сайте — редизайн, переезд на новую CMS, перекраивание структуры.

2. Взлом сайта или последствия атаки.

3. Сезонный спад активности.

4. Уменьшение интереса к теме, не связанное с сезонностью (например, как это было с криптовалютой).

Если ваша ситуация не попадает ни под одну из перечисленных историй, причину нужно искать среди внутренних SEO-факторов. Для этого мы предлагаем чек-лист самостоятельного поискового аудита. Он актуален именно для случаев, когда нужно понять причину просевшего и стагнирующего трафика.

Практика показывает, что чаще всего проблема скрывается в контенте, ссылках или поведенческих, поэтому на аудите каждой из этой группы факторов — остановимся более подробно.

Анализ контента

Тексты — важные составляющие поискового ранжирования, и проблемы с трафиком могут быть связаны именно с ними. На какие особенности контента обратить внимание, если просела посещаемость?

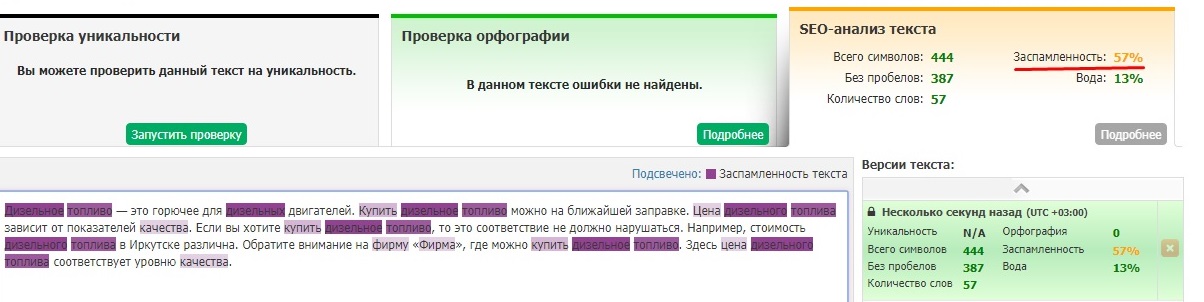

Заспамленность текста

Публикация большой партии заспамленных текстов или обновление поисковых алгоритмов, которые переиндексируют контент по новым правилам, могут стать причиной пессимизации сайта в выдаче, что сразу отразится на количестве визитов. Поэтому не лишним будет перепроверить тексты основных страниц на переспам.

Семантический анализ текстов традиционно проводят с использованием специальных инструментов — Адвего, Текст.ру и др. Но все их метрики — процент воды, стоп-слова, тошнота — имеют сомнительное отношение к реальному SEO.

Уже давно понятно, что Яндекс и Google ранжируют тексты по совершенно другим принципам. Какую же пользу можно тогда получить от семантического анализатора? Они хорошо подходят для изучения конкурентов из ТОПа выдачи Google и Яндекса. Проанализировав страницы лидеров по теме, вы сможете понять каков процент заспамленности, воды и других метрик в их текстах. Если ваши показатели существенно хуже — это повод подтянуть их до стандартов конкурентов.

Семантика

С помощью специальных SEO-анализаторов можно выгрузить семантику интересующего вас сайта и посмотреть, запросами с какой частотностью продвигаются его основные страницы. Также не лишним будет проанализировать, какие вхождения ключей чаще используют сайты из ТОПа — прямые или разбавленные.

Анализируя семантику конкурентов, также обратите внимание, как кластеры запросов коррелируются со структурой сайта. Практика показывает, что лучше продвигаются большие страницы, на которых объединяют несколько блоков тематических запросов. Стратегия, когда под каждый кластер создают отдельную страницу, демонстрирует более низкую эффективность с т.з. SEO.

Объем текстов, их структура и расположение

Сравнивая свой сайт с конкурентами, обращайте внимание на размер текстов на главной, в разделах, товарных карточках и других важных страницах. Если вы видите четкие закономерности, например, что на главной все сайты из ТОПа используют тексты размером 2-3 тыс., а у вас заметка на 500 знаков — лучше подстройтесь под их стандарты. При проведении контент-анализа сайтов из ТОПа, обращайте внимание на расположение текста на странице, структуру подзаголовков, присутствие ключевых фраз в H1, h4 и т.д.

Реакция трафика на запуск алгоритма «Баден-Баден»

Отдельно отметим, что у Яндекса и Google разная политика по отношению к контенту. Так, например, отечественный поисковик известен своей нелюбовью к портянкам на страницах категорий, в то время как Google относится к ним вполне спокойно. Поэтому если вы делаете ставку на трафик из двух поисковых систем, большие тексты в разделах можно спрятать от «Яндекса» тегом <noindex>. При этом Google будет продолжать ранжировать эти страницы вместе с контентом.

Уникальность текста

Использование уникальных текстов — основа поискового продвижения, и эта прописная истина не нуждается в излишних комментариях. Но даже у тех, кто понимает это, возможны проблемы с трафиком из-за размещения на сайте плагиата. Мы не будем рассматривать те ситуации, когда осознанно публикуют чужие тексты, а поговорим о менее очевидных случаях, когда, не зная того, можно нажить проблем с поисковыми алгоритмами.

Неуникальный контент может попасть на сайт по вине недобросовестного копирайтера. Представим, что вы заказали тексты у сомнительного фрилансера, пренебрегли проверкой и начали размещать их на сайте. Попав в индекс, большая масса неуникального контента окажется токсичной для вашего SEO. Поэтому лучше заказывать тексты на биржах, где они проходят контроль качества, либо тщательно проверять их самостоятельно, что бывает непросто, когда речь идет о больших партиях контента.

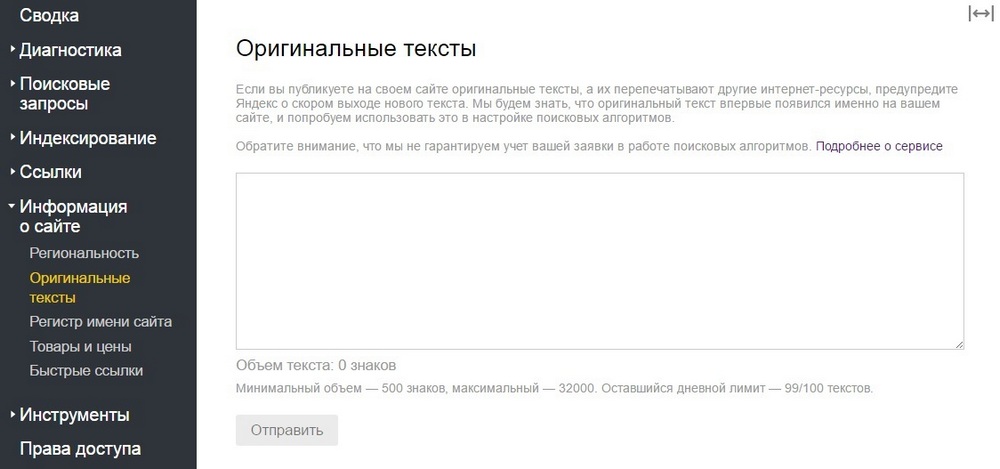

Часто тексты без ведома правообладателя перепубликовывают на других площадках. В Рунете это распространенная практика, и в большинстве случаев это никак не влияет на позиции первоисточника в выдаче. Поисковики знают за кем закреплено право авторства и с поправкой на это ранжируют сайты. Эта проблема больше актуальна для молодых проектов. Если их текст перепубликует трастовый сайт, поисковые алгоритмы смогут считать первоисточником именно его. Вероятность такого сценария особенно высока, если перехват статьи произведен сразу после ее публикации — до попадания в индекс. Подобная механика «черного» SEO сегодня доведена до автоматизации при помощи специальных скриптов.

Подавляющий процент владельцев сайтов, у которых крадут контент, не догадывается, что их же статьи в лучшем случае просто работают на другие проекты, в худшем — создают сложности для продвижения. Для решения этой проблемы «Яндекс» предусмотрел инструмент «Оригинальные тексты». Перед публикацией статьи регистрируют в вебмастере, таким образом информируя систему, кто является их первоисточником.

Проверка уникальности собственного контента — стандартная мера диагностики в ситуациях, когда проседает или перестает расти трафик. Для этих целей удобно использовать пакетное сканирование — автоматическую проверку сразу всех страниц сайта. Некоторые антиплагиатчики предлагают подобную опцию на регулярной основе: система сама производит периодическое сканирование сайта на предмет кражи контента и отправляет отчеты владельцам. Такой функционал доступен, например, в сервисе ContentWatch.

Анализ внешнего ссылочного профиля

Активная борьба со ссылочными манипуляциями — главный тренд для всех поисковых систем. Требования к внешним ссылкам в современном SEO довольно жесткие, и именно здесь, зачастую, следует искать причину упавшего или стагнирующего трафика.

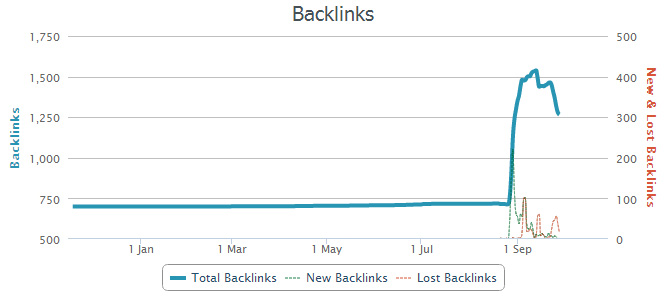

Атака конкурентов

Диагностику начинают с внимательного изучения ссылочного профиля. Подозрительное увеличение переходов с других сайтов может свидетельствовать о недобросовестных намерениях конкурентов. Цель этой черной схемы проста — искусственно завести оппонента под «Минусинск» или Penguin. Для этого на мусорных сайтах размещают большое количество анкорных ссылок, ведущих на проект, который нужно потопить. Поисковые роботы думают, что это сам владелец манипулирует со ссылками — размещает их много, быстро и непонятно где. Результат — в лучшем случае пессимизация в выдаче, в худшем — антиссылочный фильтр.

По аналогичной схеме конкуренты топят искусственной накруткой поведенческих факторов, но такое делают реже, поскольку для этого нужно больше ресурсов. А проставить несколько десятков ссылок и надеяться, что владелец сайта не обратит на них внимания — это всегда проще. Именно поэтому крайне важно отслеживать динамику ссылочного профиля, и при первых признаках сомнительной активности — связываться со службой поддержки и принимать необходимые меры.

Неправильная работа с внешними ссылками

Некоторым владельцам сайтов не нужны недобросовестные конкуренты, чтобы навредить своему проекту. С этим они успешно справляются и сами, как правило, из-за бездумного линкбилдинга. Прежде всего речь идет о неправильном обращении с внешними анкорными ссылками, которым поисковые алгоритмы традиционно уделяют повышенное внимание, как основному инструменту спамного продвижения. Избыток анкорных ссылок и реже их недостаток — частые причины проблем с трафиком.

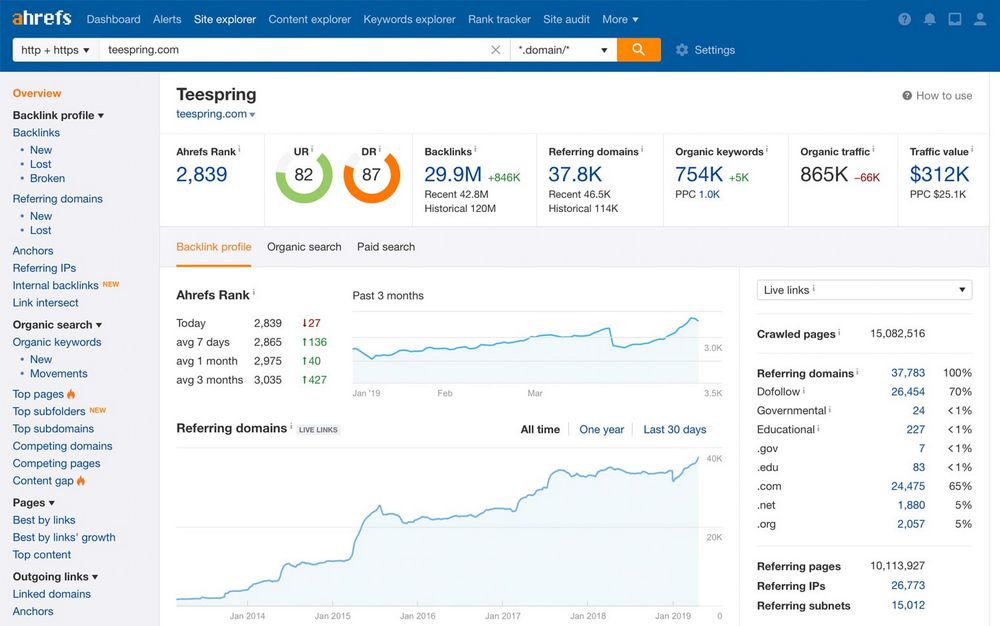

Определить перегибы в своей ссылочной политике лучше всего помогает, опять-таки, изучение ТОПа выдачи. Для этого при помощи ссылочных анализаторов выгружают анкор-листы 5-10 основных конкурентов и сравнивают плотность их анкорных ссылок со своими. Если вы видите откровенный переизбыток линков в своем профиле, превышающий средний показатель по выдачи, желательно исправить эту тенденцию. В зависимости от ситуации плотную анкорную массу либо разбавляют безанкорными конструкциями и краудом, либо подходят к решению вопроса радикально и убирают лишние ссылки.

Причиной плохого ранжирования и проблем с трафиком может быть однообразный ссылочный профиль. В эпоху современных алгоритмов эффективный линкбилдинг — это в первую очередь грамотная и сбалансированная работа с разными типами ссылок — анкорными, безанкорными, крауд-линками. Сайт может хорошо продвигаться, но в один момент, когда ссылочный перекос достигнет критической массы, скорее всего, начнутся проблемы.

Плохое качество ссылок

Качество обратной ссылки определяется авторитетностью сайта, на котором она размещена. Поэтому проставление бэклинков на ресурсах с сомнительной репутацией приводит к проблемам с трафиком. О критериях выбора доноров мы подробно рассказывали здесь. Также помимо тщательной проверки каждого сайта, при наращивании ссылочной массы важно стремиться к максимальному разнообразию доноров, чтобы не было неестественно много бэклинков с одного домена.

Анализ ссылочного донора в программе Ahrefs

Проверка и оптимизация поведенческих

Поведенческие факторы — основополагающие критерии поискового ранжирования. Их изменение на сайте с большой долей вероятности может привести к внезапным проблемам с трафиком. К основным метрикам этой группы традиционно относят:

- процент отказов;

- глубину просмотров;

- время, проведенное на сайте;

- возвраты на поиск;

- репосты в соцсетях.

На что обратить внимание, анализируя поведенческие факторы, и какие меры предпринимать?

Анализ динамики отказов. Первым делом смотрят на статистику отказов просевших страниц: какой она была и стала. Если прослеживается закономерная негативная динамика, важно понять, что за ней стоит.

Возможные причины внезапного роста отказов:

- изменился интент страницы;

- устарел контент (в выдаче появился более качественный и обстоятельный материал по теме);

- увеличилась скорость загрузки страницы или конкуренты стали быстрее;

- ухудшилось юзабилити: на сайте добавили неуместные всплывающие окна, неудачно изменили навигацию и т.д.

Количество брендовых запросов. Если пользователи часто вбивают в Google и «Яндекс» название вашего сайта, бренда или продукта — это служит важным сигналом для поисковых роботов. Если этого не происходит — сайт хуже ранжируется. По этой причине важно изучать статистику поисковых фраз, и если в ней прослеживается очевидный недостаток персонализированных запросов — следует предпринять меры. Узнаваемость бренда прокачивают при помощи крауд-маркетинговых стратегий, PR-менеджмента, грамотного ведения социальных сетей, посредством контекстной рекламы.

Уменьшение длительности пользовательских сессий. Посетители стали проводить меньше времени на сайте или же длительность сессий у конкурентов стала больше.

Как исправить эту ситуацию:

Изменить контентную политику — публикуйте больше качественных и вовлекающих статей и инвестируйте в видеоконтент.

Оптимизировать внутреннюю перелинковку — как это сделать мы подробно рассказывали здесь.

Улучшить основную навигацию и поработать с вспомогательными элементами, например, хлебными крошками.

Использовать кросс-контент на страницах — это могут быть рекомендации «Читайте по теме», блок-выдача с популярными или самыми комментируемыми статьями и т.д.

Внедрить на сайте геймификацию, публиковать тесты и опросы — все это проверенные способы удержания посетителей на сайте.

Возвраты на поиск. Пользователь переходит на сайт, проводит на нем небольшое количество времени и возвращается в поиск, продолжать искать ответ на интересующий его вопрос. Такой сценарий сигнализирует поисковым роботам, что с ресурсом не все в порядке. Контент сайта не способен удовлетворить пользовательские запросы и, соответственно, ему не место в топе поисковой выдачи. Увеличение возвратов на поиск — одна из возможных причин проблем с трафиком. Это может быть связано с рядом факторов:

- страницы входа не соответствуют запросу;

- изменился интент страницы;

- контент утратил свою актуальность — его нужно дополнить или переписать.

Сводный чек-лист

Что смотреть, если сайт перестал давать трафик?

Контент

- Тексты не переспамлены. Показатели стоп-слов, воды, тошноты и другие метрики не превышают параметров конкурентов.

- Используется эффективная семантика. Тексты оптимизированы под релевантную семантику с оптимальным соотношением высокочастотных и низкочастотных запросов (ориентируемся на показатели конкурентов).

- Применена грамотная кластеризация. Группы запросов хорошо сочетаются между собой.

- Структура сайта создана с ориентацией на семантику. Близкие по смыслу кластеры запросов не разводятся по разным страницам, а продвигаются на одной общей.

- Тексты имеют нужный размер и форматирование H1, H2, H3. В этом вопросе также ориентируемся на ТОП выдачи.

- На сайте опубликован уникальный контент.

Обратные ссылки

- Отсутствие резкого прироста сомнительных ссылок.

- В ссылочном профиле соблюден баланс анкорных и безанкорных бэклинков. Оптимальное соотношение определяется на основании анализа ссылочных профилей конкурентов.

- Использованы крауд-ссылки. Они оттеняют эффект коммерческих линков и делают профиль более разнообразным.

- Бэклинки проставлены у доноров с хорошей репутацией.

Поведенческие факторы

- Показатели отказов без негативной динамики. В противном случае обращают внимание на юзабилити, проверяют скорость загрузки, оценивают не изменился ли интент страницы и актуален ли ее контент.

- Бренд ищут в поисковиках. Отсутствие брендовых запросов — повод задействовать крауд-маркетинг и другие стратегии, направленные на повышение узнаваемости.

- Время пользовательских сессий не уменьшается. Для удержания аудитории на сайте инвестируют в качественный контент, грамотно организуют перелинковку, внедряют геймификацию и др.